(原标题:2025年全球多模态大模型行业发展现状 AI服务器和算力发展推动市场爆发式增长【组图】)

行业主要上市公司:阿里巴巴(09988.HK,BABA.US);百度(09888.HK,BIDU.US);腾讯(00700.HK, TCEHY);科大讯飞(002230.SZ);万兴科技(300624.SZ);三六零(601360.SH);昆仑万维(300418.SZ);云从科技(688327.SH);拓尔思(300229.SZ)等

本文核心数据:市场规模;算力;排名;

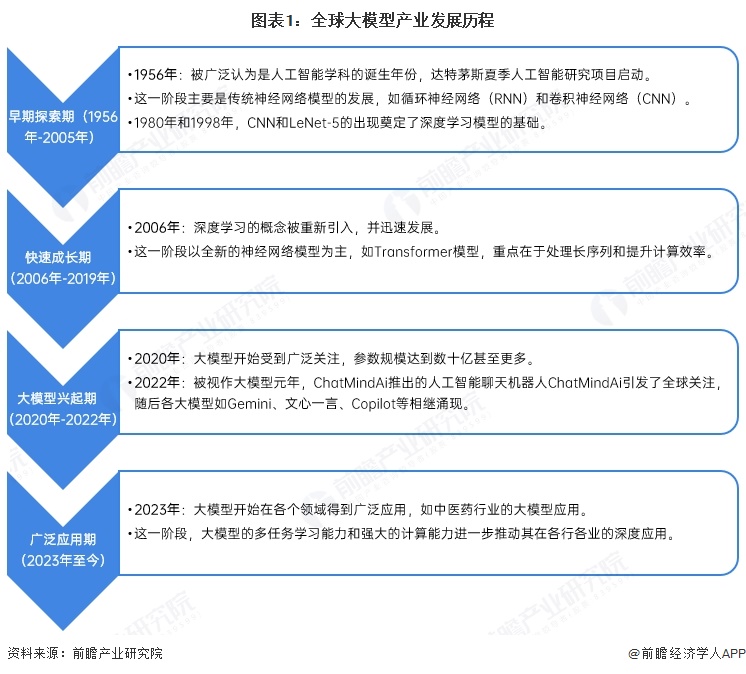

全球多模态大模型行业发展历程

全球大模型产业的发展经历了早期探索期(1956年-2005年),在这一阶段,人工智能学科诞生,神经网络模型开始发展。随后进入快速成长期(2006年-2019年),深度学习概念被重新引入,Transformer等模型推动了行业进步。2020年至2022年为大模型兴起期,参数规模迅速扩大,2022年更被视为大模型元年。从2023年开始,大模型进入广泛应用期,其在各领域的深度应用得到不断拓展。这一过程并非严格分期,而是体现了大模型技术发展的连续性和阶段性。

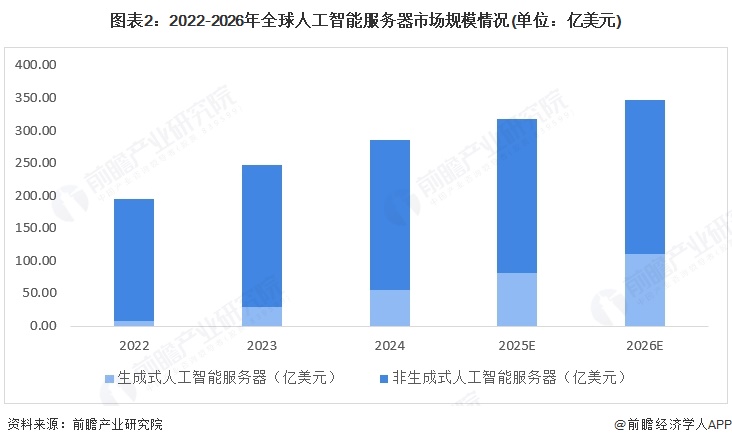

全球人工智能服务器现状

由于大模型对计算能力和数据的高需求,其所需要的服务器设施将在人工智能基础设施市场中占据越来越大的份额。IDC预计,全球人工智能硬件市场(服务器),将从2022年的195亿美元增长到2026年的347亿美元,五年年复合增长率达17.3%;其中,用于运行生成式人工智能的服务器市场规模在整体人工智能服务器市场的占比将从2023年的11.9%增长至2026年的31.7%。

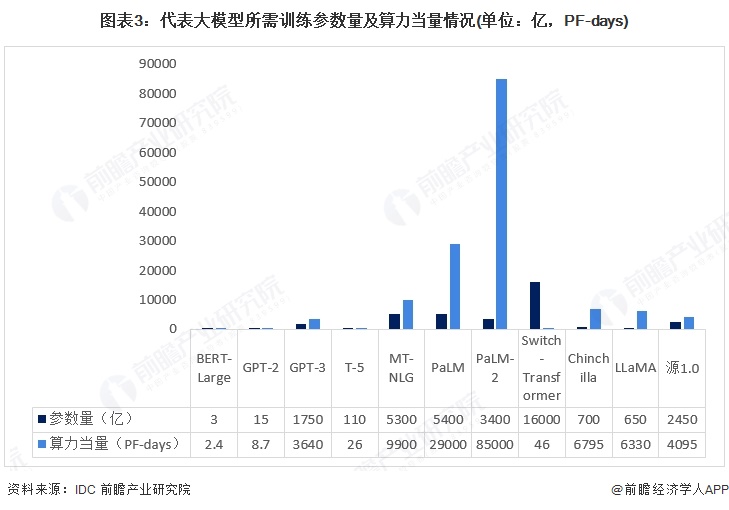

全球大模型算力需求情况

从感知智能到生成式智能,人工智能越来越需要依赖“强算法、高算力、大数据”的支持。模型的大小、训练所需的参数量等因素将直接影响智能涌现的质量,人工智能模型需要的准确性越高,训练该模型所需的计算力就越高。以ChatGPT模型为例,公开数据显示,其所使用的GPT-3大模型所需训练参数量为1750亿,算力消耗为3640PF-days(即每秒运算一千万亿次,运行3640天),需要至少1万片GPU提供支撑。据统计,当模型参数扩大十倍,算力投入将超过十倍,模型架构、优化效率、并行处理能力以及算力硬件能力等因素均会影响具体增加的倍数。

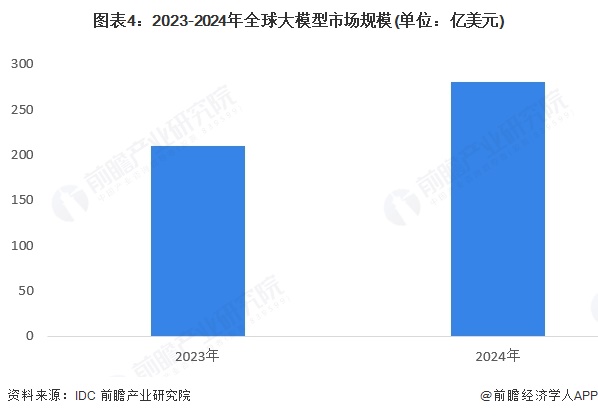

全球大模型市场规模情况

当前全球的人工智能产业处于高速发展期,大模型技术引领着人工智能领域正在迈向新的发展高度,也已不局限于技术讨论的范畴,而是进入商业化应用阶段,大模型市场正处于快速增长阶段。根据IDC数据,2023年全球大模型市场规模达到210亿美元。初步测算,2024年全球大模型市场规模达280亿美元,同比增长33%。

全球多模态大模型竞争格局

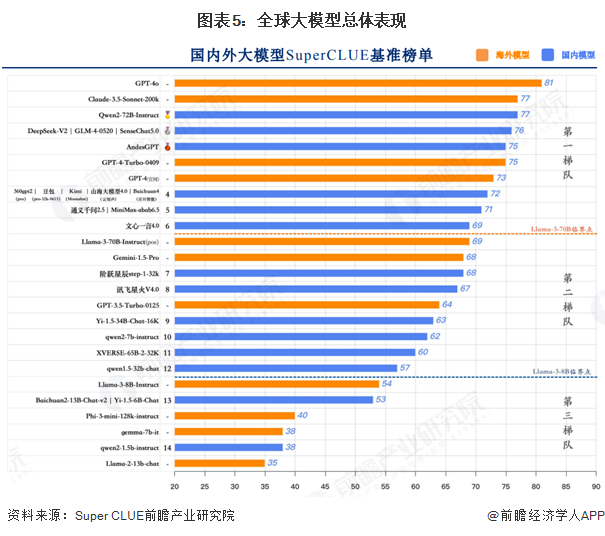

2024年7月9日,SuperCLUE发布《中文大模型基准测评2024上半年报告》,报告选取国内外有代表性的33个大模型在6月份的版本,通过多维度综合性测评,对国内外大模型发展现状进行观察与思考。从代表通用能力的一级总分来看,GPT-4o以81分的绝对优势领跑SuperCLUE基准测试,是全球模型中唯一超过80分的大模型。展现出强大的语言、数理和指令遵循能力。中国大模型发展非常迅速,其中有6个国内大模型超过GPT-4-Turbo-0409。绝大部分闭源模型已超过GPT-3.5-Turbo-0125。

注:由于部分模型分数较为接近,为了减少问题波动对排名的影响,本次测评将相距1分区间的模型定义为并列,报告中分数展示以上区间为主;截至2025年4月,暂未有2024年全年报告,届时以最新数据为准。

更多本行业研究分析详见前瞻产业研究院《全球及中国多模态大模型行业发展前景与投资战略规划分析报告》